Atari(雅达利) 游戏作为经典的游戏始祖,玩家们的乐趣在于如何去获得最高的分数,打破记录。而近期,人工智能公司 DeepMind 在官方博客宣布了 AI 挑战 Atari 游戏的新进展,称在57款 Atari 游戏中实现全面超越人类,是该领域里的第一次。

在 DeepMind 最新发布的预印本论文和博客中称,他们构建了一个名为 Agent57 的智能体,通过在街机学习环境(Arcade Learning Environment,ALE)中学习,从而在 57 个 Atari 游戏中表现超越人类。如果 Agent57 智能体有如此优秀,那么将会为构建更加强大的 AI 决策模型奠定基础,可以进行自动推理环境,实现自动化提升生产力。

DeepMind 为什么选择用 Atari 游戏来进行测试呢?其实早在2012年,DeepMind 开发出 Deep Q-Network(DQN),同样是用于挑战 Atari 57款游戏。但当时不能克服四款比较难的游戏:Montezuma’s Revenge、Pitfall、Solaris 和 Skiing。

这一次同样採用游戏的一部分原因可能是想弥补缺憾,另一部分原因是 Atari 游戏的一些特点。据悉 Atari 有3个特点,第一是游戏足够多样性,可以用来评估智能体的泛化性能;第二是可以模拟真实环境中的情况;第三是因为 Atari 游戏由独立的组织构建,可以有效避免实验偏见。

除此之外,DeepMind 在博客上公布了 Agent57 的框架,採用强化学习算法,在多台电脑上运行。这可以让 AI 赋能的智能体选择最大化奖赏去执行指令。 OpenAI 的 OpenAI Five 和 DeepMind 的 AlphaStar RL 智能体分别打败过 99.4% 的 Dota 2 玩家和 99.8% 的星际2玩家。

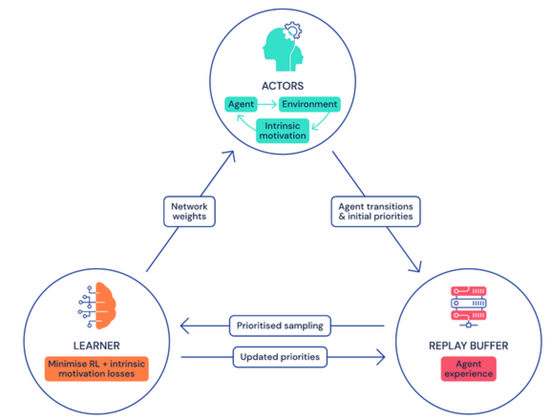

Agent57 的学习过程是通过把众多 actor 信息汇总到可以採样的一个中央存储库中来进行学习。 DeepMind 团队为了更好的的学习,採用两种不同的 AI 模型来近似每个状态动作的价值(state-action value),价值能够决定智能体的执行指令好坏程度,从而提供评估标準,让智能体适应性选择使用哪种策略。

这个全新的框架模型有着两个优势,一是有着策略优先级选择,让 Agent57 去分配更多的网络容量;二是在评估时採用自然的方式来选择最佳策略。

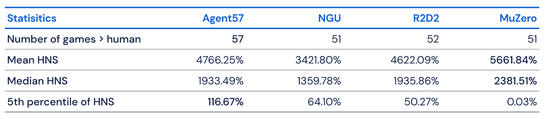

Agent57 在与 MuZero、R2D2 和 NGU 等领先算法的比较中,总体上限更高。在训练 50亿帧后就可以在 51种游戏上超越人类,而在训练 780亿帧后可以在 Skiing 游戏上超越人类。

虽然 Agent57 已经在51种游戏上超越了人类,但是 DeepMind 团队并不满于此,向我们透漏了下一步计划「Agent57 最终在所有基準测试集最困难的游戏中都超过了人类水平。但这并不意味着 Atari 游戏研究的结束,我们不仅要关注数据效率,也需要关注总体表现……未来的主要改进可能会面向 Agent57 在探索、规划和信度分配上。」期待在未来,AI 能够带来更多生活上的便捷。

云骑士一键重装系统